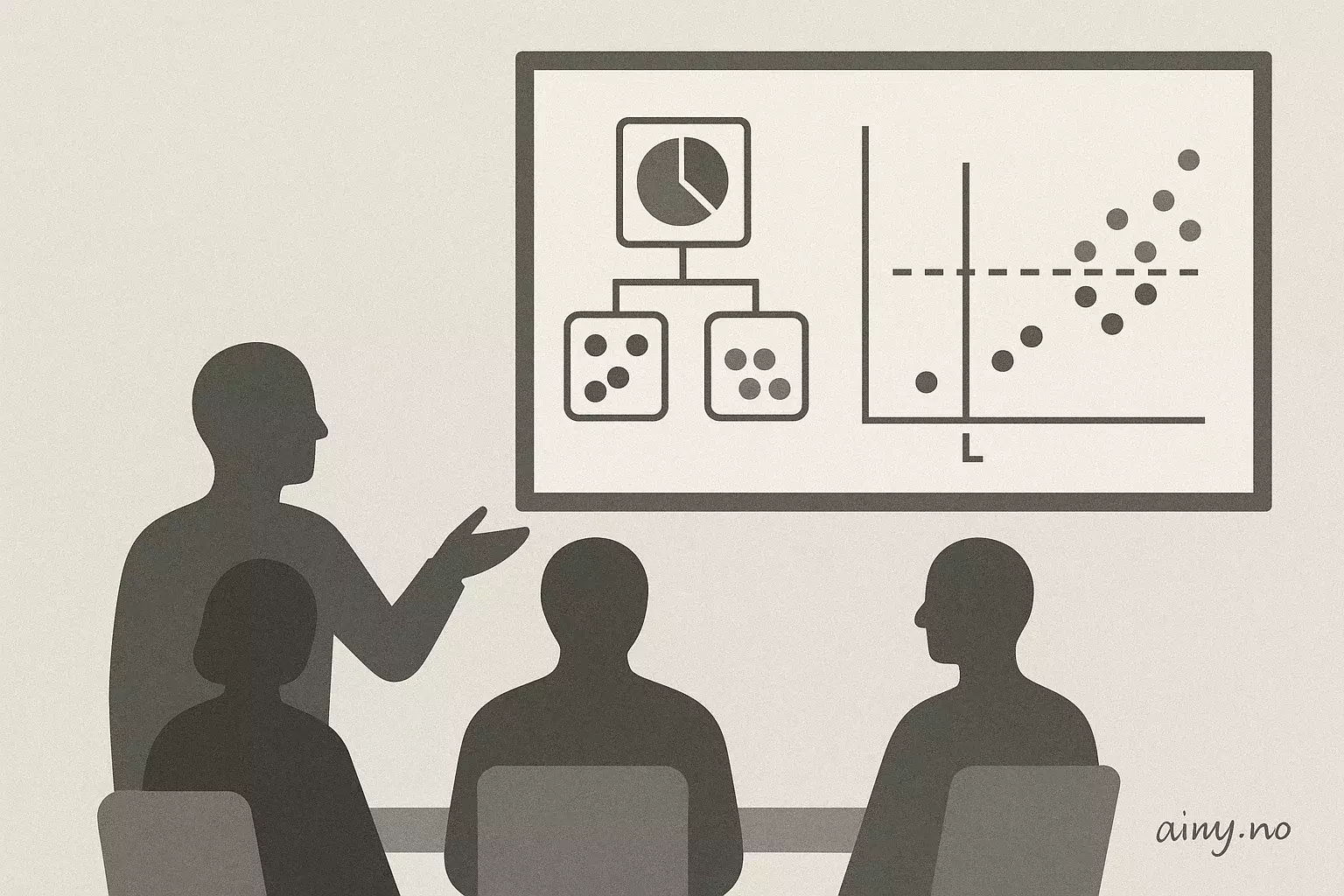

Forklaring av hvordan en Decision Tree Classifier velger sin første splitt ved hjelp av impuritetsmål.

Modellen tester alle mulige splittpunkter mellom sammenhengende, sorterte verdier og beregner for hver kandidat impuriteten i venstre og høyre region. For hver side telles antall observasjoner per klasse, andelene p beregnes og Gini-impuritet (eller entropi) utregnes; splitten vurderes med vektet impuritet og den med lavest verdi velges. Metoden kan enkelt organiseres i en syntetisk tabell i Excel som viser Gini (venstre), Gini (høyre) og vektet Gini for hver kandidat. Dette illustrerer grunnprinsippene i beslutningstrær innen kunstlig intelligens (KI), og scikit-learn bruker Gini som standard.

Prinsippet generaliseres direkte til flerklassetilfeller ved å inkludere flere p‑termene i Gini-formelen, og strukturen i algoritmen forblir den samme. Gini og entropi oppfører seg likt (null ved ren node, maksimal ved jevn fordeling) og fører som regel til samme splitt; forskjellen ligger i at Gini er kvadratisk mens entropi er logaritmisk, men i praksis er avvikene små — et tema av interesse i AI-nyheter.

Temaets praktiske framstilling i Excel og kobling til standardbiblioteker gjør det relevant for AI-Norge og norske utviklere som jobber med modeller og verktøy som scikit-learn.

Kilde: https://towardsdatascience.com/the-machine-learning-advent-calendar-day-7-decision-tree-classifier | Sammendraget er KI-generert med OpenAI API og kvalitetssikret av redaksjonen i Ainy.no