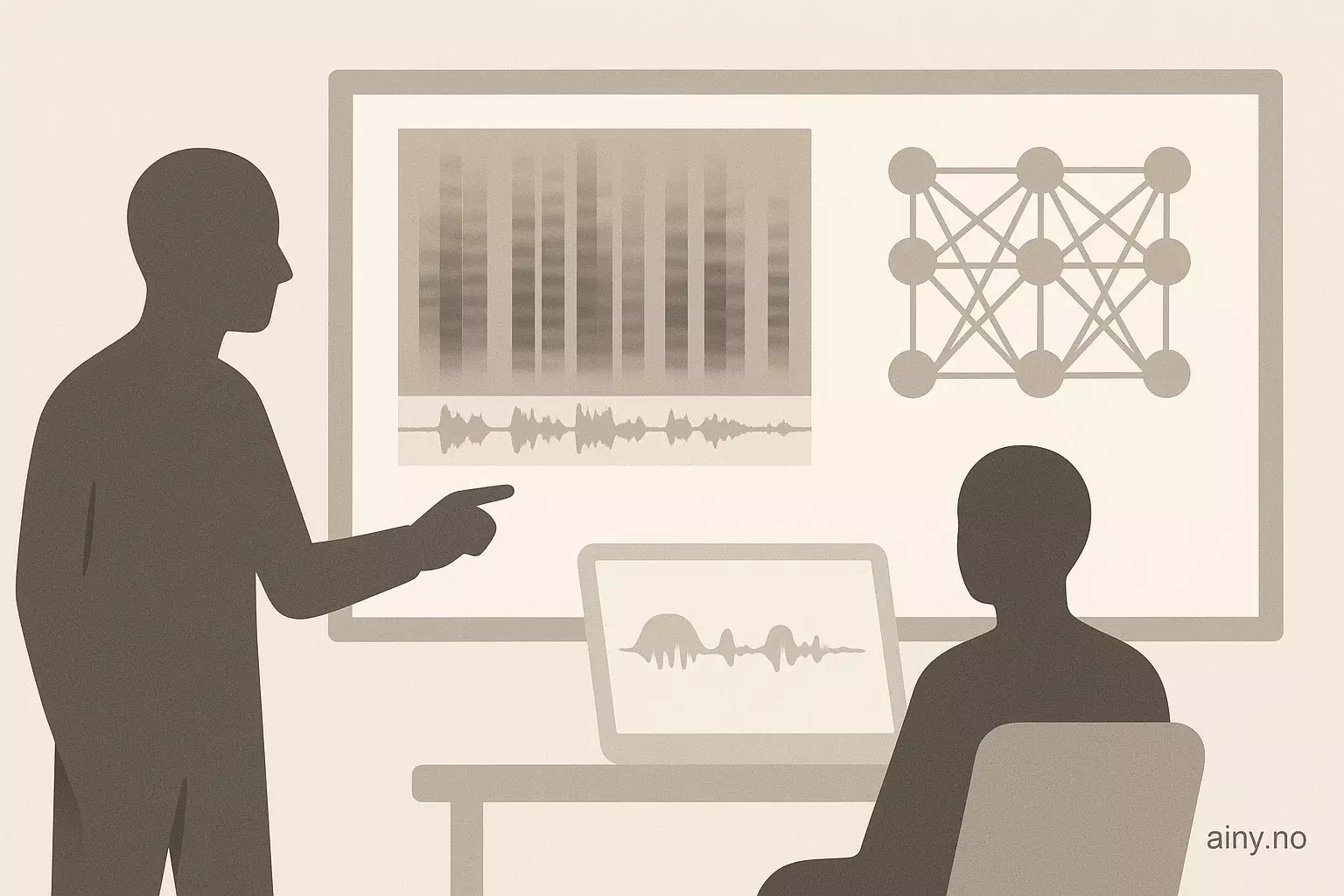

Konvolusjonsnevrale nettverk kan lære likhet mellom sanger ved å lage numeriske lydrepresentasjoner fra mel-spektrogram.

Metoden konverterer lydfiler til mel-spektrogram, en 2D-visning av frekvens over tid tilpasset menneskelig hørsel. Nettverket tar korte, tilfeldige utdrag (chunks) på 128×129 fra spectrogrammene i batcher på åtte, og produserer en 128-dimensjonal vektor for hvert utdrag. Under trening legges små støyforstyrrelser til for å lage to «visninger» av hvert utdrag. Et kontrastivt mål (InfoNCE) bruker likheter mellom vektorene for å gjøre vektorene fra samme lyd mer like enn vektorer fra andre lydklipp. Dette gir lydembeddings som fanger timbre, rytme og tekstur, og kan sammenlignes effektivt i anbefalingssystemer. Dette er en anvendelse av kunstlig intelligens (KI) i musikk.

I AI-nyheter er dette relevant fordi store strømmetjenester som Spotify og Apple Music trenger gode anbefalinger; embedding-baserte systemer skalerer bedre når det er mange spor og brukere, noe som kan gi en bedre lytteopplevelse også for norske brukere.

Kilde: https://towardsdatascience.com/how-convolutional-neural-networks-learn-musical-similarity | Sammendraget er KI-generert med OpenAI API og kvalitetssikret av redaksjonen i Ainy.no