AWS presenterte 21. november 2025 en referansearkitektur kalt Multi-Provider Generative AI Gateway for å samle tilgang, styring og overvåking av generative modeller fra flere leverandører.

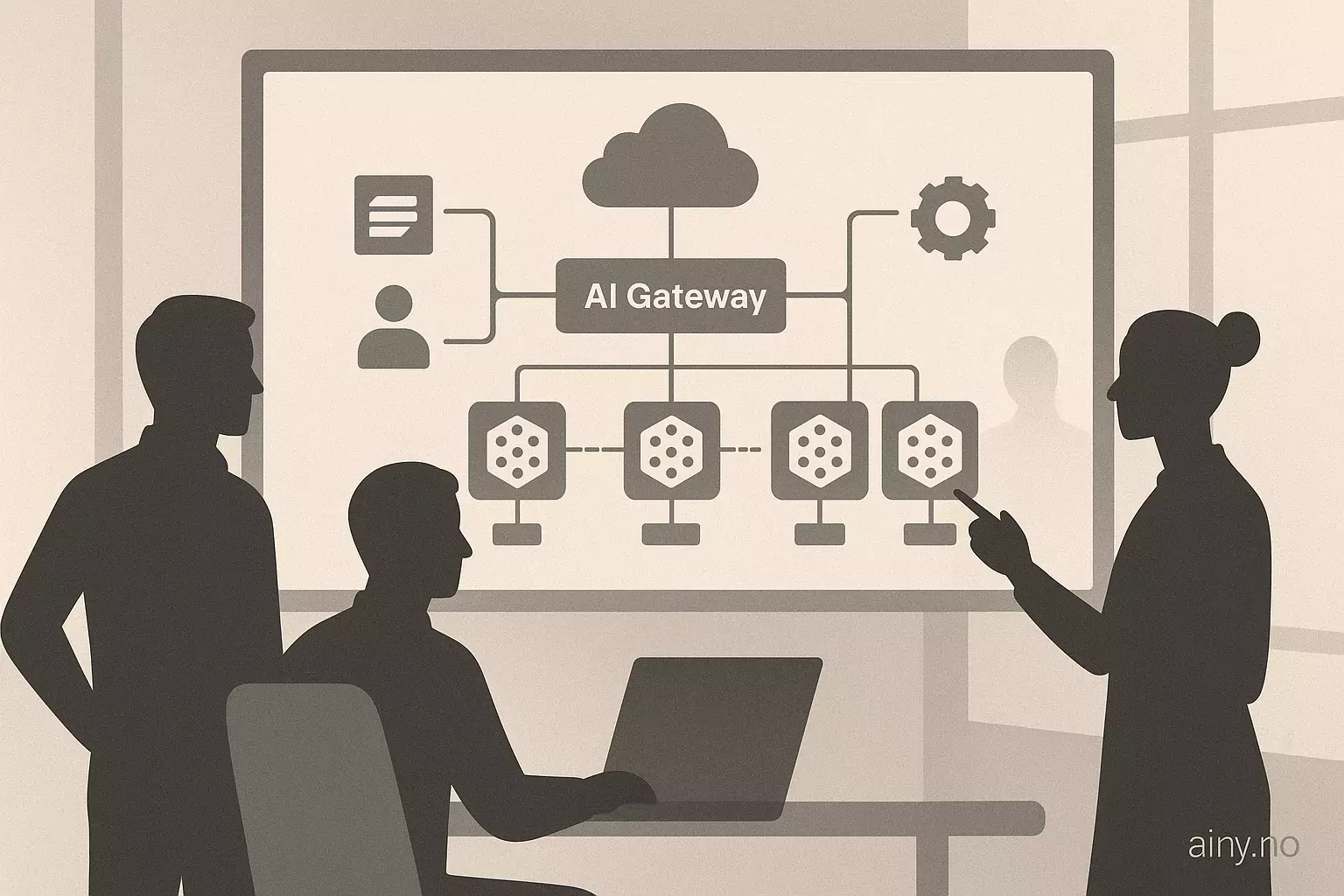

Referansearkitekturen kombinerer Amazon Bedrock, Amazon SageMaker AI og det åpne kildeprosjektet LiteLLM for å forenkle flerleverandør-tilgang og standardisere produksjonskrav som kostnadssporing, observabilitet og prompt-håndtering. Løsningen skal hjelpe bedrifter med å møte utfordringer som leverandørfragmentering, desentralisert styring, operasjonell kompleksitet, kostnadskontroll og krav til sikkerhet og revisjon. Arkitekturen gir veiledning for produksjonsdistribusjon av LiteLLM i AWS-miljøer og tilbyr flere distribusjonsmønstre (Amazon ECS og Amazon EKS) samt nettverksvalg for global offentlig distribusjon med Amazon CloudFront, regional direkte-tilgang via Application Load Balancer (ALB) eller privat intern tilgang i VPC. Administrasjonsfunksjonene i LiteLLM inkluderer et sentralisert webgrensesnitt for bruker- og teamadministrasjon, API-nøkkelhåndtering med revisjonsspor, budsjettkontroller og varsling, lastbalansering, prompt-caching og støtte for flere SDK-er (Boto3, OpenAI og LangGraph). Arkitekturen støtter modeller fra Amazon Bedrock, Amazon SageMaker AI, OpenAI og Anthropic, og kan benytte Bedrock-guardrails.

Løsningen er relevant for norske virksomheter som tar i bruk kunstlig intelligens (KI) fordi den tilbyr sentralisert styring, sikkerhet og kostnadskontroll; dette er av interesse for AI Norge og omtales i AI-nyheter.

Kilde: https://aws.amazon.com/blogs/machine-learning/streamline-ai-operations-with-the-multi-provider-generative-ai-gateway-reference-architecture | Sammendraget er KI-generert med OpenAI API og kvalitetssikret av redaksjonen i Ainy.no